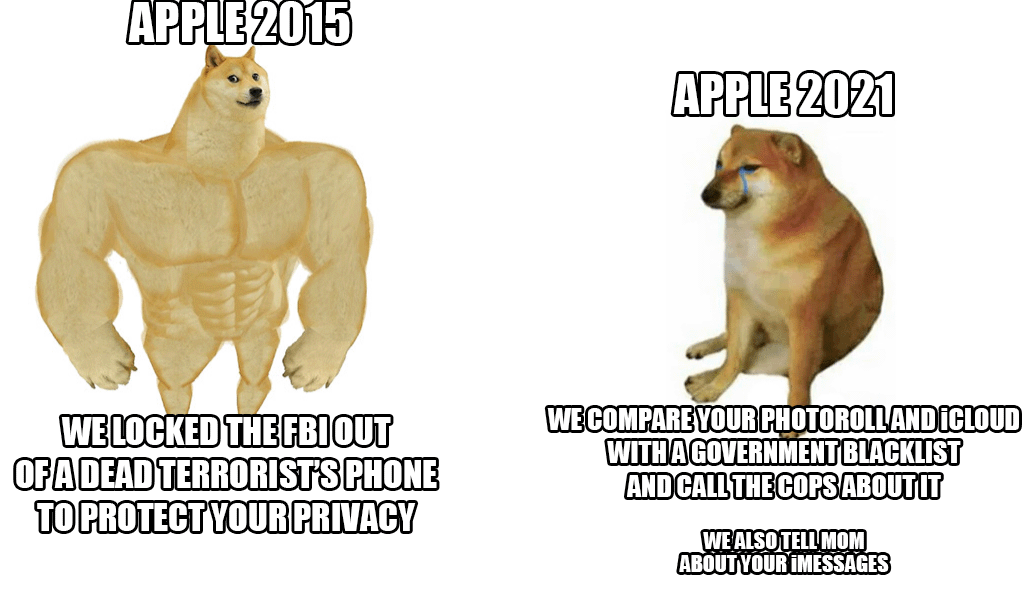

Ende letzter Woche stellte Apple ein neues System zur Bekämpfung von Kindesmissbrauch vor, das die iCloud-Fotos praktisch aller Personen scannt. Obwohl die Idee auf den ersten Blick gut klingt, da Kinder vor dieser Aktion unbedingt geschützt werden müssen, wurde der Cupertino-Riese dennoch heftig kritisiert – nicht nur von Nutzern und Sicherheitsexperten, sondern auch aus den Reihen der Mitarbeiter selbst.

Nach neuesten Informationen einer angesehenen Agentur Reuters Mehrere Mitarbeiter äußerten in einer internen Mitteilung auf Slack ihre Besorgnis über dieses System. Angeblich sollen sie Angst vor einem möglichen Missbrauch durch Behörden und Regierungen haben, die diese Möglichkeiten beispielsweise zur Zensur von Personen oder ausgewählten Gruppen missbrauchen könnten. Die Enthüllung des Systems löste eine heftige Debatte aus, die bereits über 800 Einzelnachrichten innerhalb des oben genannten Slack umfasst. Kurz gesagt, die Mitarbeiter sind besorgt. Sogar Sicherheitsexperten haben zuvor darauf hingewiesen, dass es sich in den falschen Händen um eine wirklich gefährliche Waffe zur Unterdrückung von Aktivisten, der erwähnten Zensur und dergleichen handeln würde.

Die gute Nachricht (bisher) ist, dass die Neuheit nur in den USA starten wird. Derzeit ist noch nicht einmal klar, ob das System auch innerhalb der EU-Staaten zum Einsatz kommen wird. Doch trotz aller Kritik bleibt Apple standhaft und verteidigt das System. Er argumentiert vor allem damit, dass die gesamte Prüfung innerhalb des Geräts erfolgt und sobald eine Übereinstimmung vorliegt, erst in diesem Moment das Gehäuse erneut von einem Apple-Mitarbeiter überprüft wird. Nur nach seinem Ermessen erfolgt die Übergabe an die zuständigen Behörden.

Es könnte sein interessiert dich

Ich würde ungern von iCloud zu etwas Sicherem und wirklich Privatem wechseln, aber wenn Apple darauf besteht, werde ich trotzdem aufhören, sie zu bezahlen.

Es wird (vorerst) nur in den USA aktiv sein

Es spielt keine Rolle, wo es gesetzgeberisch Anwendung finden wird. Diese Technologie wird bereits verfügbar sein und eingesetzt werden. Das ist das größte Risiko.