In den letzten Jahren hat sich die Welt der Mobiltelefone stark verändert. Wir können grundlegende Unterschiede in praktisch allen Aspekten erkennen, unabhängig davon, ob wir uns auf Größe oder Design, Leistung oder andere intelligente Funktionen konzentrieren. Die Qualität von Kameras spielt derzeit eine relativ große Rolle. Im Moment könnte man sagen, dass dies einer der wichtigsten Aspekte von Smartphones ist, bei denen die Flaggschiffe ständig konkurrieren. Wenn wir beispielsweise Android-Telefone mit dem iPhone von Apple vergleichen, stellen wir außerdem eine Reihe interessanter Unterschiede fest.

Es könnte sein interessiert dich

Wenn Sie sich für die Welt der mobilen Technologie interessieren, dann wissen Sie sicherlich, dass einer der größten Unterschiede bei der Sensorauflösung liegt. Während Androids oft ein Objektiv mit mehr als 50 Mpx anbieten, setzt das iPhone seit Jahren nur auf 12 Mpx und kann immer noch bessere Fotos liefern. Bildfokussierungssystemen wird jedoch nicht viel Aufmerksamkeit geschenkt, wobei wir auf einen recht interessanten Unterschied stoßen. Konkurrierende Handys mit Android-Betriebssystem setzen oft (teilweise) auf den sogenannten Laser-Autofokus, während Smartphones mit dem „Bitte Apple“-Logo nicht über diese Technologie verfügen. Wie funktioniert es eigentlich, warum wird es eingesetzt und auf welche Technologien setzt Apple?

Laserfokus vs. iPhone

Die erwähnte Laserfokussierungstechnologie funktioniert ganz einfach und ihr Einsatz ist sehr sinnvoll. In diesem Fall ist im Fotomodul eine Diode versteckt, die beim Drücken des Auslösers Strahlung aussendet. In diesem Fall wird ein Strahl ausgesendet, der vom fotografierten Motiv/Objekt abprallt und zurückkehrt. Diese Zeit kann genutzt werden, um mithilfe von Softwarealgorithmen schnell die Entfernung zu berechnen. Leider hat es auch seine Schattenseiten. Beim Fotografieren in größeren Entfernungen ist der Laserfokus nicht mehr so genau, oder beim Fotografieren von transparenten Objekten und ungünstigen Hindernissen, die den Strahl nicht zuverlässig reflektieren können. Aus diesem Grund verlassen sich die meisten Telefone immer noch auf den bewährten Algorithmus zur Erkennung des Szenenkontrasts. Ein solcher Sensor kann das perfekte Bild finden. Die Kombination funktioniert sehr gut und sorgt für eine schnelle und genaue Bildfokussierung. Beispielsweise verfügt das beliebte Google Pixel 6 über dieses System (LDAF).

Auf der anderen Seite haben wir das iPhone, das etwas anders funktioniert. Aber im Kern ist es ganz ähnlich. Beim Drücken des Auslösers spielt die ISP- oder Image Signal Processor-Komponente eine Schlüsselrolle, die in den letzten Jahren erheblich verbessert wurde. Dieser Chip kann die Kontrastmethode und ausgefeilte Algorithmen nutzen, um sofort den besten Fokus zu ermitteln und ein qualitativ hochwertiges Foto aufzunehmen. Natürlich ist es aufgrund der gewonnenen Daten notwendig, das Objektiv mechanisch in die gewünschte Position zu bewegen, aber alle Kameras in Mobiltelefonen funktionieren auf die gleiche Weise. Obwohl sie von einem „Motor“ gesteuert werden, ist ihre Bewegung nicht rotierend, sondern linear.

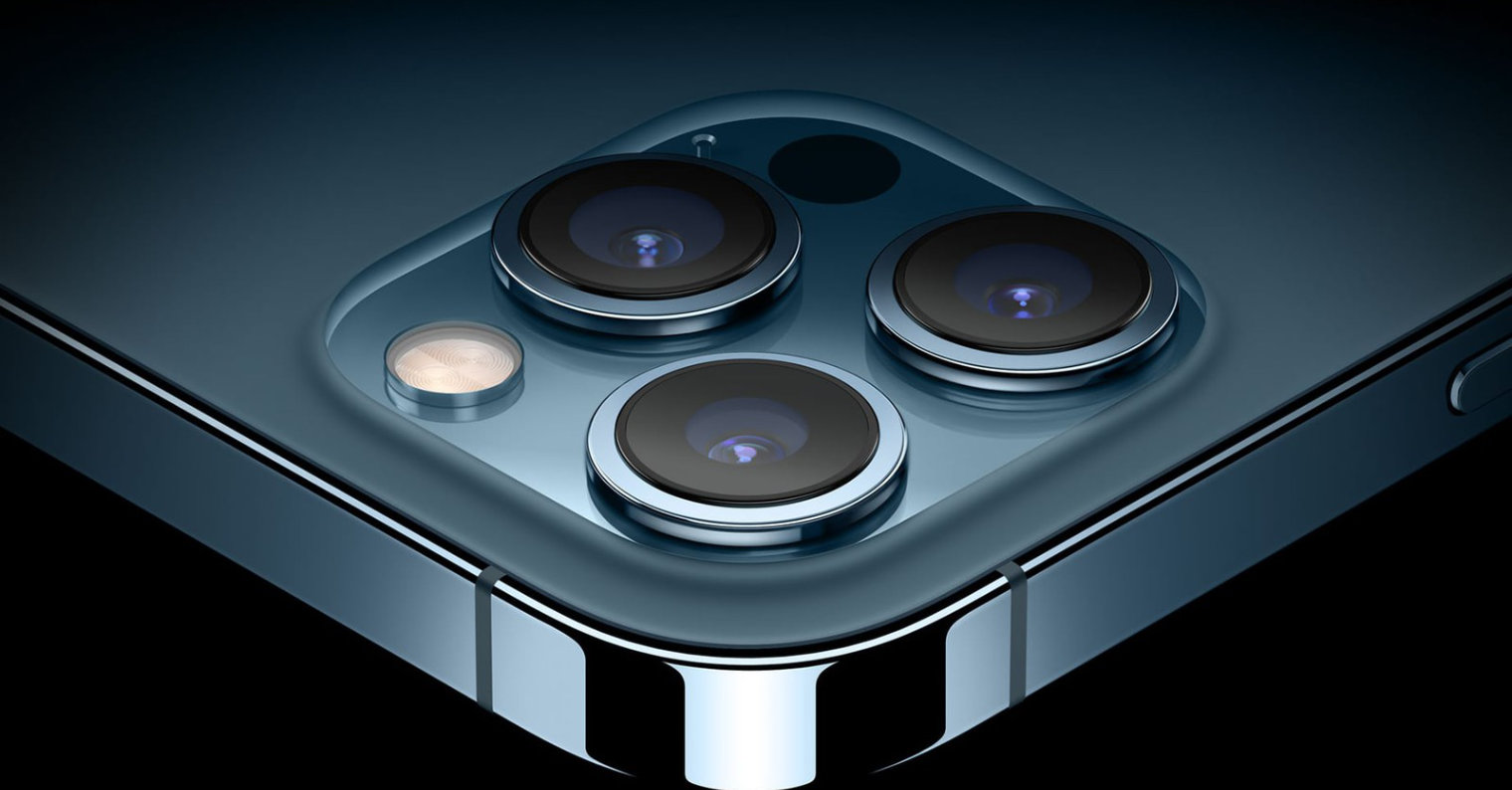

Einen Schritt voraus sind die Modelle iPhone 12 Pro (Max) und iPhone 13 Pro (Max). Wie Sie vielleicht schon vermutet haben, sind diese Modelle mit einem sogenannten LiDAR-Scanner ausgestattet, der sofort die Entfernung zum fotografierten Motiv ermitteln und dieses Wissen zu seinem Vorteil nutzen kann. Tatsächlich kommt diese Technologie dem erwähnten Laserfokus nahe. LiDAR kann mithilfe von Laserstrahlen ein 3D-Modell seiner Umgebung erstellen und wird daher hauptsächlich zum Scannen von Räumen, in autonomen Fahrzeugen und zum Aufnehmen von Fotos, vor allem Porträts, eingesetzt.

Es könnte sein interessiert dich

Adam Kos

Adam Kos

Mit Apple um die Welt fliegen

Mit Apple um die Welt fliegen