Forscher der chinesischen Universität Zheijiang haben etwas sehr Interessantes herausgefunden: Intelligente Assistenten in Mobiltelefonen (in diesem Fall Siri und Alexa) können auf ganz einfache Weise angegriffen werden, ohne dass der Besitzer des angegriffenen Geräts davon ahnungslos ist. Ultraschallgesteuerte Angriffe sind für das menschliche Ohr nicht hörbar, aber das Mikrofon in Ihrem Gerät kann sie erkennen und, wie sich herausstellt, in vielen Fällen befehlen.

Es könnte sein interessiert dich

Diese Angriffsmethode nennt sich „DolphinAttack“ und funktioniert nach einem sehr einfachen Prinzip. Zunächst ist es notwendig, menschliche Sprachbefehle in Ultraschallfrequenzen (Band 20 Hz und höher) umzuwandeln und diese Befehle dann an das Zielgerät zu senden. Für eine erfolgreiche Tonübertragung ist lediglich ein Telefonlautsprecher erforderlich, der an einen kleinen Verstärker und einen Ultraschalldecoder angeschlossen ist. Dank des empfindlichen Mikrofons im angegriffenen Gerät werden die Befehle erkannt und vom Telefon/Tablet als klassische Sprachbefehle seines Besitzers interpretiert.

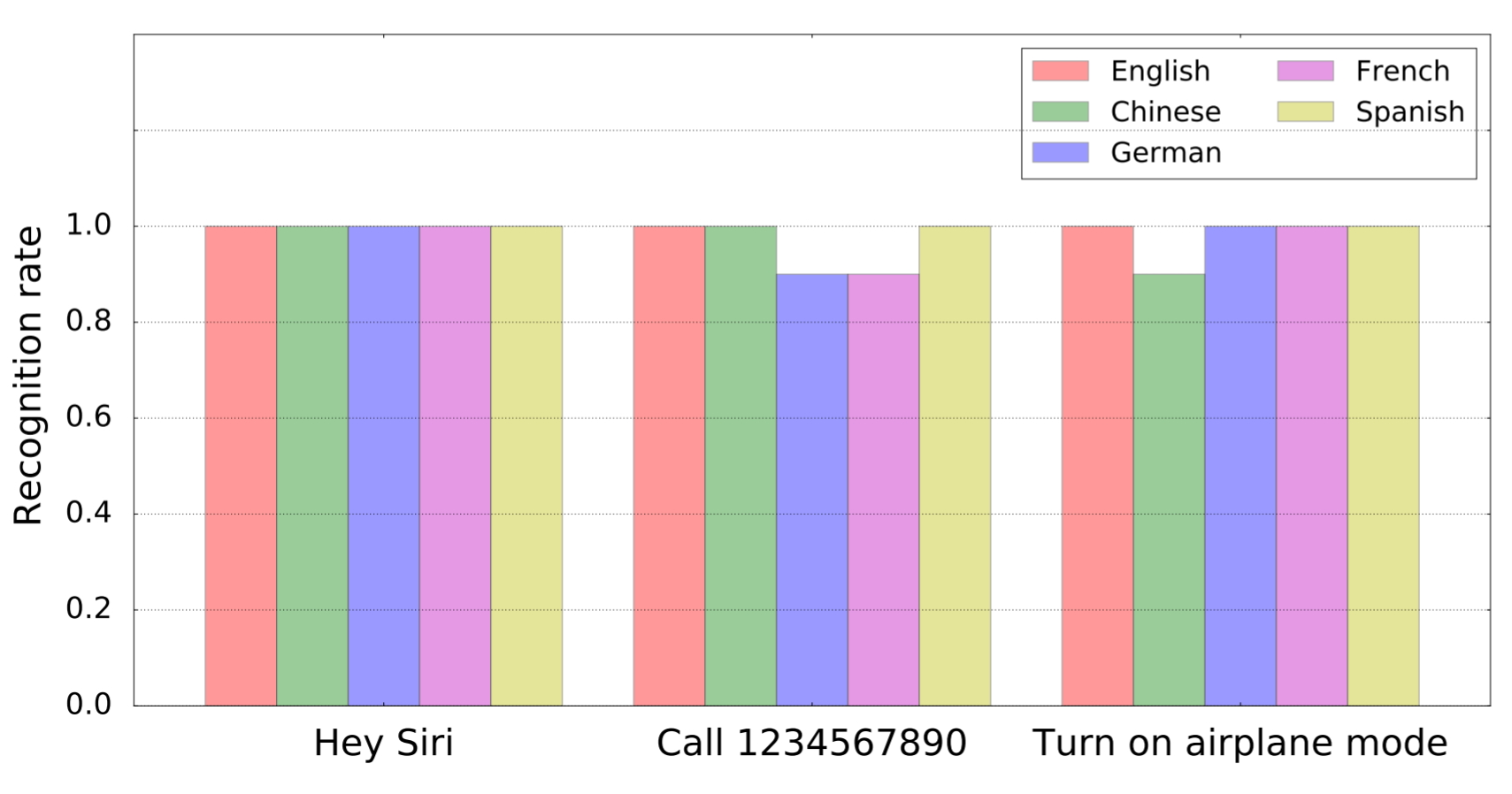

Im Rahmen der Recherche stellte sich heraus, dass grundsätzlich alle weiblichen Assistenten auf dem Markt auf solche angepassten Aufträge reagieren. Ob Siri, Alexa, Google Assistant oder Samsung S Voice. Das getestete Gerät hatte keinen Einfluss auf das Testergebnis. Die Reaktion der Assistenten wurde daher sowohl vom Telefon als auch von einem Tablet oder Computer empfangen. Konkret wurden iPhones, iPads, MacBooks, Google Nexus 7, Amazon Echo und sogar Audi Q3 getestet. Insgesamt gab es 16 Geräte und 7 verschiedene Systeme. Ultraschallbefehle wurden von allen registriert. Was vielleicht noch gruseliger ist, ist die Tatsache, dass die geänderten (und für das menschliche Ohr unhörbaren) Befehle auch von der Spracherkennungsfunktion erkannt wurden.

Bei den Tests kamen mehrere Verfahren zum Einsatz. Von einem einfachen Befehl zum Wählen einer Nummer über das Öffnen einer diktierten Seite bis hin zum Ändern bestimmter Einstellungen. Im Rahmen des Tests war es sogar möglich, das Navigationsziel des Autos zu ändern.

Die einzig positive Nachricht an dieser neuen Methode, das Gerät zu hacken, ist die Tatsache, dass es derzeit auf etwa eineinhalb bis zwei Meter Entfernung funktioniert. Die Abwehr wird schwierig sein, da die Entwickler von Sprachassistenten die Häufigkeit der wahrgenommenen Befehle nicht begrenzen wollen, da dies zu einer schlechteren Funktion des Gesamtsystems führen könnte. In Zukunft muss jedoch eine Lösung gefunden werden.

Source: Engadget

Da Sie den Artikel übersetzen, hätten Sie ihn verständlicher machen können. Im englischen Original ist die Funktionsweise viel weniger verwirrend. Verteidigung ist trivial. Ignorieren Sie einfach die Befehle, die nur über Ultraschallfrequenzen erfolgen.

Ja, und wie im Artikel erwähnt, werden die Entwickler nicht damit fortfahren, Befehle von Ultraschallfrequenzen zu ignorieren, da nicht ganz klar ist, wie sich dies auf die resultierende Qualität und Erkennungsfähigkeit klassischer Sprachbefehle auswirken würde.

Nein, im Artikel heißt es, das Spektrum zu zerhacken. Ich habe vorgeschlagen, die Eingabe zu ignorieren, die nur aus dem Ultraschallteil des Spektrums besteht.